Data Science

Wij analyseren data om daarmee betrouwbare voorspellingen te kunnen maken voor de toekomst, hiervoor gebruiken wij verschillende data mining technieken. Voor het "bedrijven" van data science is het tegenwoordig eenvoudig een standaardpakket te gebruiken, er gegevens in te stoppen en resultaten uit te halen. Het is echter van belang dat

deze resultaten ook betrouwbaar zijn en de data scientist snapt wat hij aan het doen is.

Vaak moet er worden geinvesteerd in prototypes en wordt eerst de kwaliteit van de brondata verbeterd. Als de juiste data aanwezig is zorgt data science ervoor dat het management makkelijker (onderbouwde)

beslissingen kan nemen met behulp van DDD (Data-Driven Decision Making) technieken. Onderzoek heeft aangetoond dat de winst van bedrijven die DDD technieken gebruiken significant hoger is dan die van bedrijven die dit niet gebruiken en beslissingen nemen

op "gevoel". Het is echter helaas zo dat de juiste data voor het maken van analyses niet altijd aanwezig is en eerst "gevonden" moet worden. In dit laatste geval zal gekeken worden welke data intern verkregen kan worden en welke data eventueel gekocht moet worden.

Data science is een iteratief proces, echter een ander iteratief proces dan bij software ontwikkel trajecten, het gaat bij data science

meer om strategie en de juiste aanpak dan bij software ontwikkeling, na de eerste resultaten krijgt de data scientist meestal verbeterde inzichten en zal terug gaan naar de ontwerp fase.

Een voorbeeld is een Data Science traject: Het bepalen of de bushaltes van Arriva op de juiste plek staan, we doen dit door te kijken naar o.a. de GPS coordinaten van "deuropen" momenten in de data verzameld door de

verschillende bussen en deze data te groeperen en de betrouwbaarheid ervan te bepalen. Het gaat hierbij om enorme hoeveelheden data die worden opgeslagen en verwerkt moeten. Arriva rijdt met honderden bussen die

elk duizenden records per dag schrijven. De database met MIPOV (Model Informatieprofiel Openbaar Vervoer) gegevens van Arriva groei momenteel met ongeveer 20 waarnemingen per seconde.

Via big data technieken wordt de juiste data verzameld en volgens statistische (econometrische) methoden

wordt de betrouwbaarheid bepaald.

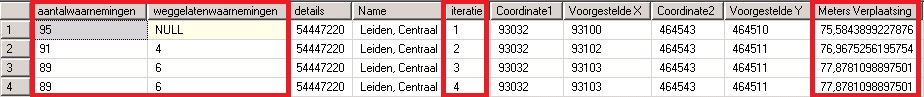

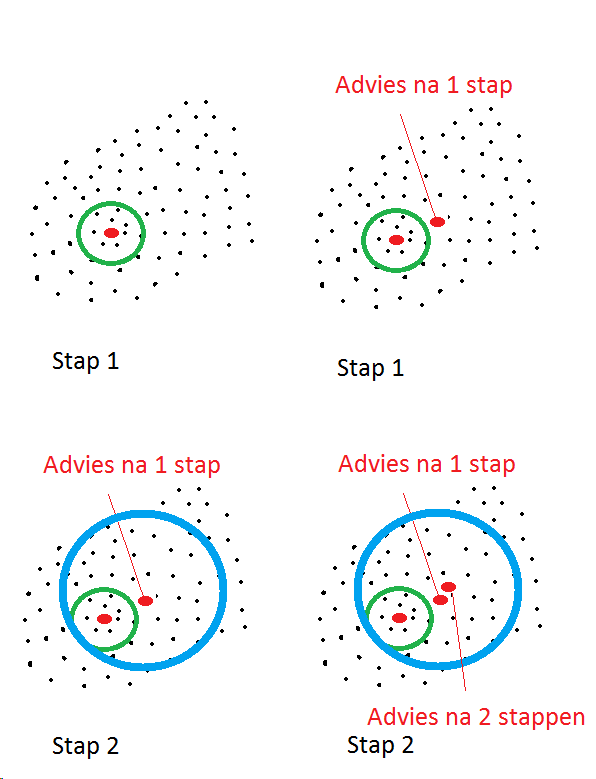

Hieronder staat een voorbeeld, waarin waarnemingen zijn samengevoegd, waarbij de data via iteraties steeds betrouwbaarder wordt.

Voor Openinterim.com hebben wij een model ontwikkeld dat de latente behoeften voor interim opdrachten voorspeld, op deze manier kunnen we kandidaten

aanbieden VOORDAT de klant met de aanvraag de markt betreed, het gaat hierbij om een "voorspellend" model ook wel machine learning genoemd.

Roelofs ICT Consultancy zet data science in om (on)gestructureerde data om te zetten in inzichten voor het beter besturen van allerlei zaken.

Voor deze data gedreven voorspellingen maken wij o.a. gebruik van SQL Server Analysis Services (SSAS) en

SQL Reporting Services (SSRS).

Data verzamelen gebeurt op internet continu, bijvoorbeeld op facebook, zie hierachter een voorbeeld over migratie gecreeerd uit data van facebook: Data science door Facebook